生成AIは多くの業務で活用が広がりつつありますが、その一方で「もっともらしい誤情報を出してしまう」という課題に直面する利用者が増えています。

いわゆるハルシネーションと呼ばれるこの現象は、正しいかどうかの見分けがつきにくいため、ユーザー自身が注意しないと大きなトラブルを引き起こし兼ねません。

この記事では、ハルシネーションとは何か、その原因や具体的なリスク、そして防ぐために取れる実践的な対策を整理します。

2025年9月にOPENAIより公開された最新の知見も踏まえて解説するため、最新事情に基づいて判断できる点が特徴です。

読み終えるころには、生成AIを業務に取り入れる際に気をつけるべきポイントと、安心して活用するための基礎知識が身につきます。

AIを味方にしながら成果を出したい方にとって、有益な一歩となる内容です。

ハルシネーションとは?

この章では、生成AIに特有の誤情報生成現象について定義を整理し、用語の意味とビジネス利用への影響を理解できるようにします。

AI分野におけるハルシネーションの定義

ハルシネーションとは、生成AIが事実に基づかない内容を出力してしまう現象を指します。

AIの特性は、謝りをあたかも正確な事実であるかのように出力することです。

正確な事実であるかのように自信満々に出力するからこそ、ユーザーは騙されてしまうのです。

AIがハルシネーションを起こす理由は、そもそも元のデータとなる情報が誤っている場合やユーザーが与える情報が不十分で質問の意図と回答のズレが生じている場合などがあります。

検索エンジンの誤ヒットや単純なタイポとは異なり、出力全体が一貫性を持っているため見抜きにくい点が課題です。

ChatGPTに多い事例の特徴

ChatGPTをはじめとする対話型AIでは、質問者の意図をくみ取ろうとするあまり、実在しない書籍や論文を生成してしまうケースがしばしば見られます。

典型的なのは、参考文献としてと求められた際に存在しない著者名や出版年をもっともらしく提示する事例です。

これはモデルが確率的に妥当な組み合わせを導き出している結果であり、知識の有無を判断しているわけではありません。

こうした現象は特定の分野や専門領域で顕著になり、ユーザーが専門外の情報を鵜呑みにする危険を増大させます。

ユーザーは出力の自然さと正確性が必ずしも一致しないことを意識する必要があります。

生成AI利用時にハルシネーションが発生する原因

なぜAIがもっともらしく誤情報を返すのか、仕組みを理解することで対策の必要性を把握できます。

学習データの量と質の問題

AIの学習量や質に問題がある場合は、正しいデータが生成されません。

例えば最新の出来事や専門分野に関しては十分なデータが存在せず、AIが予測で穴埋めしようとします。

情報のバラツキが生じる主な要因は、以下の3点です。

- 古い情報が含まれている:学習時点での知識にとどまり、最新の出来事や技術を反映できない

- 質の低い記事が混在している:誤情報や主観的な意見が多いと、AIの判断も不正確になる

- 情報源の偏り:特定のメディアや地域のデータが多い場合、視点や解釈に偏りが生まれる

AIの情報を扱うときは、「必ずしも100%正しいとは限らない」という前提を持つことが大切です。

出力を鵜呑みにせず、根拠や一次情報を確認する習慣が、AI時代のリテラシーといえるでしょう。

プロンプト設計や入力内容の影響

AIに与える指示が曖昧であるほど、出力が不安定になる傾向があります。

例えば「この理論を詳しく説明して」とだけ入力すると、AIはどの理論のどの部分を深掘りすればいいのか分からず、関連しそうな情報をいろいろ混ぜて説明してしまうことがあります。

ここで欲しい回答を得るには「〇〇理論について、マーケティング観点での重要ポイントを3つ」「一般的な日本の中学生が理解できるように」など、条件や目的を具体的に指定すると効果的です。

ただし、工夫をしたとしてもAIの出力が100%正確になるわけではないことも理解しておきましょう。

AIの仕組み上による限界

生成AIは、人間のように「知識を理解して覚えている」わけではなく、言葉のパターンを統計的に予測して文章を作る仕組みです。

そのため、学習していない情報を聞かれると、「それっぽい答え」を作ってしまうことがあります。これがハルシネーション(誤情報の生成)です。

どんなに高性能なモデルでも、この傾向を完全に消すことはできません。

2025年10月にOPEN AIが発表したハルシネーションに関する事実

2025年9月にOpenAIが公表した報告では、ハルシネーションの発生を助長する仕組みとして評価システムの設計が注目されました。

AIは正確に答えるよりも、自信を持って答えることを優先する傾向があります。

誤っていても断定的に回答するほうが、システム内部で「良い出力」と判断されるケースがあります。

学習段階で人間の好む回答を高く評価する設計が影響しており、AIが正確さよりも説得力を重視する傾向を生みます。

この発表は、従来の「学習データ」「プロンプト設計」「モデル構造」といった要因に加え、AI評価の仕組みそのものを見直す必要があることを示しています。

今後は、AIが「わからない」と答えられるようにする仕組みや、人間が結果を検証するプロセスの強化が信頼性向上の課題になります。

ハルシネーションがもたらすリスク

業務利用における信頼性低下や信用失墜など、実際に生じ得る問題を理解し適切に備えることができます。

個人利用での信用や成果物への影響

最も大きなリスクは、誤った情報をそのまま成果物に取り入れてしまい、自身の信用を損なう点です。

例えば調査レポートや記事にAI生成の誤情報を掲載すれば、読者やクライアントに誤解を与え、訂正や謝罪に追われる可能性があります。

さらに、一度でも誤りが目立つと「また間違うのではないか」という不信感が積み重なり、長期的な評価低下につながります。

文章が論理的かつ自然に見えるからこそ、情報が誤っていたときには大きなトラブルや信頼低下に繋がりやすいのです。

正確性を担保する仕組みを持たないまま依存することは、個人レベルでも深刻なリスクです。

フリーランスとクライアント関係へのリスク

フリーランスにとって、納品物の正確性は信頼関係の基盤です。

ハルシネーションが混じった提案や成果物を提出すると、クライアントからの信用を一気に失い、継続案件の打ち切りや契約解除につながる危険があります。

実際に「参考文献として提示したURLが存在しなかった」という小さなミスでも、専門性が疑われるきっかけとなります。

クライアント側がAIの特性を十分に理解していない場合には、利用者が事前にAI利用のリスクを十分に伝えましょう。

対策を講じることで信頼を守る余地がある点を見落とさないことが大切です。

企業導入における法務やコンプライアンスリスク

組織的な利用では、誤情報が契約や意思決定に影響するリスクが顕著になります。

例えば、生成AIが作成した社内文書に誤った法的解釈が含まれていれば、重大な契約トラブルに発展しかねません。

また、誤った医療情報や金融情報を基にした提案は、法的責任を問われる可能性すらあります。

加えて、AI利用に関する規制やガイドラインが整備されつつある中で、ハルシネーションを放置すれば「管理不足」とみなされ、組織全体のリスクマネジメント評価に悪影響を及ぼすでしょう。

企業利用においては、単なる効率化ツールではなく「法務リスクの発生源」として捉える視点が欠かせません。

ハルシネーションを抑える基本対策

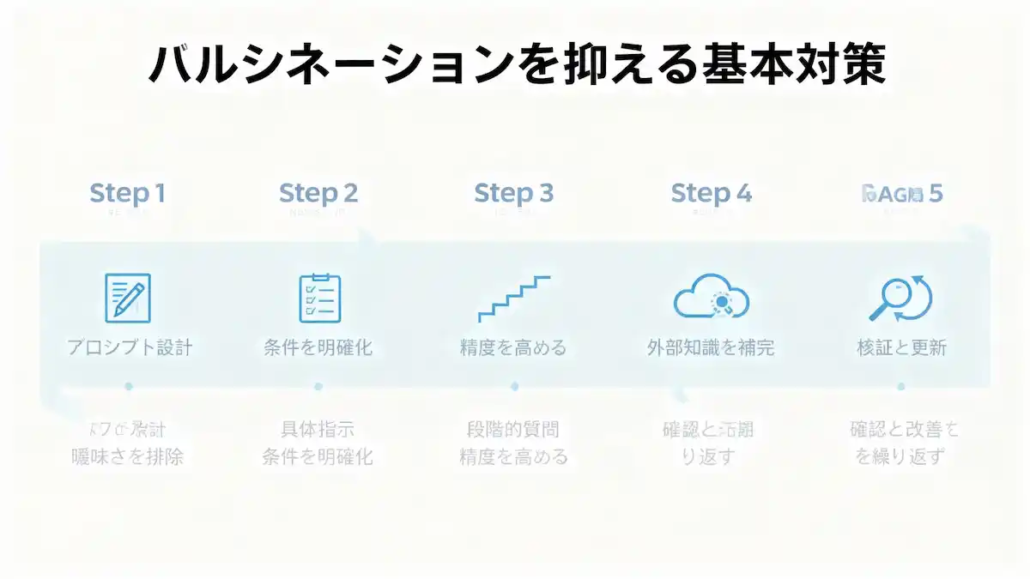

1. プロンプト(指示文)をしっかり設計する

AIが間違える大きな原因のひとつは、質問があいまいなことです。

例えば「詳しく説明して」よりも、「〇〇の定義を300字以内で、一次情報の出典を添えて説明して」と伝える方が、AIは正確な答えを出しやすくなります。

質問の目的や条件を具体的にすることで、AIの精度がぐっと上がります。

2. 指示内容や条件を具体的に伝える

AIに曖昧さを残さないことが重要です。

「300字以内で」「箇条書きで」「初心者にもわかるように」など、形式や視点を明示してあげると、出力のブレが少なくなります。

ただし、制約を細かくしすぎると逆に窮屈になることもあるため、必要な条件だけ伝えるくらいのバランスが理想です。

3. 一度に聞かず、段階的に質問する

複雑な内容を一度に聞くと、AIが混乱して誤答することがあります。

「まず定義を確認」「次に事例を紹介」「最後にまとめて」といった流れで、段階的にやりとりを重ねると精度が上がります。

この“分けて聞く”という工夫が、ハルシネーションを防ぐ一番シンプルな方法です。

4. 外部情報を活用してAIを補う

AIは過去のデータをもとに学習しているため、最新情報や専門的な内容には弱い面があります。

そこで役立つのが、外部データを参照できるRAG(ラグ)という仕組みです。

社内文書や信頼できる公的サイトを検索対象に設定すれば、AIが“知らない情報”を補って答えられるようになります。

特別な技術が必要な場合もありますが、最近は手軽に使えるツールも増えています。

5. モデルを最新の状態に保つ

AIはモデル(仕組み)が新しいほど精度が高い傾向にあります。

同じ質問でも、古いモデルと最新モデルでは答えの正確さがまったく違うことがあります。

ただし、どんなモデルにも間違いはあるため、常に最新を使う+結果を確認するのセット運用が基本です。

ハルシネーション対策を業務に組み込む方法

個人と企業それぞれの立場で、日常的に安全に生成AIを使うための仕組みを設計できるようにします。

フリーランスに向けたチェックリスト

フリーランスは自らの成果物に責任を持つため、ハルシネーション対策を日常的に取り入れることが不可欠です。

基本は「生成→確認→修正」の三段階を徹底することです。

具体的には、AIの回答をそのままクライアントに渡さず、必ず事実確認を行い、参考文献を突き合わせる習慣を持つ必要があります。

具体的には、納品前に「固有名詞や数値は一次ソースに基づいているか」をチェックリスト化すれば、ミスを未然に防げます。

チーム利用時のマニュアル整備

マニュアルに生成AIの利用範囲・必須の検証プロセス・責任の所在を明文化しておけば、属人的な判断によるリスクを抑えられます。

例えば「AIの出力は必ず二人以上で確認する」「重要文書はAI出力を直接利用しない」などのルールを取り入れると有効です。

ただし、運用ルールが過度に厳しすぎると利用者の負担が増え、かえってAI活用が停滞する恐れがあります。

したがって、現場に合った柔軟なガイドラインを定期的に更新することが重要です。

セキュリティや情報管理ルールとの連動

ハルシネーション対策は単独では不十分であり、情報セキュリティやデータ管理の枠組みと連動させる必要があります。

例えばIPAやNISTのガイドラインを参考に、AI利用ポリシーを社内規程と統合すれば、誤情報発生時の責任範囲や対応手順を明確にできます。

フリーランスであっても、契約先から情報管理体制を問われるケースは増えており、対策の有無が案件受注に直結する可能性があります。

ハルシネーション以外に注意すべきAIリスク

偏った視点を避けるため、他に存在するリスクを押さえて総合的に理解することができます。

著作権や学習データのライセンス問題

AIの活用では、出力が学習データの著作物に依拠している可能性が常につきまといます。

最大の課題は「どこまでが引用で、どこからが権利侵害か」が不明確な点です。

特に文章や画像を生成する際、既存作品に酷似したアウトプットが出ればトラブルになり得ます。

背景には、AIが膨大なデータを学習して統計的に再構成する仕組みがあるため、利用者が意図せず権利侵害をしてしまう危険があることがあります。

これを軽視すると、訴訟や損害賠償につながる恐れもあるため、権利関係に敏感である必要があります。

プライバシー侵害や情報漏洩のリスク

生成AIに個人情報や機密情報を入力することは、情報漏洩につながる大きな懸念です。

入力データが学習に再利用される可能性や、外部に保存される仕組みが透明化されていない場合もあり、安心して扱うには制限を設けるしかありません。実際に海外では、AIに入力した顧客情報が外部に流出し問題となった事例も報告されています。

一方で、利用規約やセキュリティ設定を確認すれば一定のリスクは抑制できます。

したがって、AIの利便性と情報保護のバランスを取る姿勢が必要です。

過度依存による判断力低下

便利さに惹かれてAIに過度に依存すると、利用者自身の判断力や思考力が低下する恐れがあります。

例えば、文章生成やアイデア出しをすべてAIに任せてしまえば、独自の視点や創造力を育てにくくなります。

これは短期的には便利でも、長期的には専門家としての価値を損なう可能性があります。

AIは補助ツールであり、主体的な判断や批判的思考を維持することが利用者の責任です。

ここで問い直したいのは「自分はAIに任せすぎていないか」という点です。

ハルシネーションを防ぐための学び方(どこで学ぶ?何を使う?)

AIが誤情報を生む大きな理由のひとつは、「分からなくても答えようとする仕組み」にあります。

だからこそ学びの場を選ぶときは、「分からない」と言える姿勢と、答えを裏付ける環境の両方を整えることが大切です。

ここでは、その力を身につけられる学び方やツールをご紹介します。

BitlandAI(ビットランドAI)|テンプレ×エージェントで“誤りにくい雛形”を量産

ビットランドAI(BitlandAI)は、短期間で成果物を形にしながら、自然に「誤りにくい習慣」を身につけたい方に向いています。

特徴:テンプレートを活用して誰でもすぐに成果物を形にできる学習環境。

向き:プロンプトに自信がなくても、まずは成果物をすぐ形にしたい個人や小規模チーム。

学びになる点:300種類以上のテンプレートで構造を固定し、出力には根拠脚注ブロックを必ず付与。さらに業務特化エージェントで固有名詞や数値を一次ソースと突き合わせれば、検証の流れを自然に習慣化できます。操作が直感的なので、初学者でも“誤りにくい”土台を短期間で身につけられるのが魅力です。

費用の目安:月額980円〜+従量課金。小さく始めて効果を検証しながら継続を判断できます。

※最新の料金・条件は必ず公式で確認してください。

実際に導入した利用者からは「正確性のチェックが自然に習慣化できた」との声もあり、検証工数を削減できるメリットがあります。

特にリソースの限られた小規模チームにとっては、導入ハードルが低く成果に直結しやすい点が安心材料となるでしょう。

AI CONNECT|職種別講座×就職支援で“わからない”を評価する実務型レビュー

AI CONNECTは知識を体系的に学びながら、レビューを通して実務に直結するスキルを定着させたい人におすすめです。

特徴:職種別のカリキュラムと実務レビューを通じて、体系的に学べる環境。

向き:体系的に学び、レビューを受けながら実務やキャリアに直結させたい人。

学びになる点:不確実性を減点しないレビュー票により、誤答よりも「保留」を評価する姿勢を体感できます。さらに面談や添削で一次情報の探し方や引用スキルを強化でき、学んだ知識をそのまま実務へ接続可能。学習とキャリア支援が一体化している点が大きな魅力です。

費用の目安:要件を満たせば実質無料枠あり

※対象講座や条件は最新の募集要項を確認してください。

「費用の心配を抑えつつ専門的に学びたい」というニーズに応えやすく、安心してスキル習得に集中できます。

実務評価と学習支援が一体となっているため、学んだ内容がそのままキャリア形成につながる点も評価されています。

当サイトサポート|あなた専用の“評価表+RAG+運用設計”を90日で内製

自分やチームの状況に合わせて、AI活用を安全に定着させたい方には、当サイトでサポートも可能です。

特徴:既存業務に合わせて、評価・検証の仕組みをオーダーメイドで設計。

向き:既存の業務フローにAIを安全に組み込み、自分や組織に合った評価と検証の仕組みを作りたい人。

提供内容:根拠率や不確実性を測る評価表、RAG用ソースリスト整備、反証クエリの設計などを90日で内製化します。運用面まで伴走することで「ルールがあるから安全に使える」という安心感を実現。特に小規模チームにとって、無理なく導入できる点が強みです。

費用の目安:ヒアリング後にスポット型と週次伴走型をご提案。まずは無料相談フォームから安心してご利用いただけます。

カスタマイズ性が高いため「標準サービスでは対応しきれない課題」を持つ組織にも適応可能です。

実際に運用に落とし込むプロセスを伴走支援することで、机上の知識にとどまらない実効性を確保できます。

以下のアンケートにご回答ください。

https://www.surveyrock.com/ts/DRNKXQ

生成AIのハルシネーションについてのよくある質問

ここでは、記事本文を読んだ後に読者が抱きやすい疑問を整理しました。

理解を深め、安心して生成AIを業務に取り入れるためのサポートになるため、ぜひ参考にしてください。

ハルシネーションは完全に防げるのですか?

ハルシネーションを完全に防ぐことはできません。

AIは統計的にもっともらしい文章を生成する仕組みを持つため、必ず一定の確率で誤情報が出てしまいます。

ただし、プロンプトを具体的に設計する、RAGを活用する、最新モデルを選ぶといった工夫で発生率を下げることは可能です。

さらに、利用者がファクトチェックを徹底すれば実務上のリスクは大幅に軽減できます。

ChatGPTのハルシネーションはなぜ見抜きにくいのですか?

自然で一貫性のある文章を生成するため、内容が誤っていても正しく見えることが多いからです。

特に参考文献や専門用語に関しては、実在しない情報をもっともらしく提示するケースが目立ちます。このため、出力をそのまま信じず、公式情報源や一次資料を必ず確認する姿勢が欠かせません。

フリーランスが取るべき実践的な対策はありますか?

チェックリストを作り、AI出力をそのままクライアントに渡さないことが基本です。

固有名詞や数値を一次ソースで検証する、重要部分は別の質問で再確認する、といったプロセスを日常的に組み込むと信頼を守れます。AI利用のリスクをクライアントに伝えておくことも、トラブル防止につながります。

企業が導入時に注意すべき点は何ですか?

法務やコンプライアンスリスクを明確に管理することが必要です。

誤情報が契約や意思決定に反映されれば大きな損失につながります。

そのため、利用ルールや検証手順をマニュアル化し、責任の所在を定めておくことが求められます。IPAやNISTのガイドラインを参考にすると安心です。

ハルシネーション以外に生成AIにはどんなリスクがありますか?

著作権問題や情報漏洩、AIへの過度依存といったリスクも存在します。

生成AIは利便性が高い一方で、権利侵害やプライバシー侵害につながる危険を含みます。

また、使いすぎると利用者自身の判断力低下を招きかねません。AIを補助的に使い、自らの責任で最終判断する姿勢が大切です。

まとめ|ハルシネーションを理解して活用するために

生成AIのハルシネーションは、学習データやモデル構造、プロンプト設計の問題など複数の要因から必然的に生じる現象です。

重要なことはハルシネーションを完全に防ぐことはできないという前提を持ちながら、利用者自身がリスクを管理する仕組みを備えることです。

本記事で触れたように、プロンプト改善やRAG導入、モデルの選択と更新、ファクトチェックの習慣化など具体的な対策を実務に取り入れることで、安全に生成AIを活用できます。

フリーランスにとっては信用維持、企業にとってはコンプライアンス確保が最大の課題ですが、いずれの立場でも「仕組みを持つ」ことが信頼の基盤となります。

利用者は、AIの便利さを享受する一方で「疑う力」を保ち続けることが不可欠です。この記事を読んだ今こそ、自身の利用スタイルを見直し、ハルシネーションを前提とした活用法を実践に移していくことが望まれます。

フリーランスの一般的な働き方については、「フリーランスとは?始め方・年収・職種をわかりやすく解説【完全ガイド】」で詳しく解説しているので、理解しておきたい方はぜひ参考にしてください。

また、生成AIの活用法や対策については、当サイトでもサポート可能です。

まずはご状況について以下のアンケートに回答いただけたら、具体的なサポートやアドバイスをさせていただきます。

https://www.surveyrock.com/ts/DRNKXQ